CCV2025 UrbanLLaVA,城市大脑觉醒?具备空间推理与理解能力的城市智能多模态大语言模型!

清华大学研究团队提出UrbanLLaVA,这一多模态大语言模型(MLLM)创新性地解决了城市研究中多模态数据整合的难题。该研究通过构建包含街景图像、卫星图像、地理空间数据和轨迹数据的城市指令数据集(UData),设计了多阶段训练框架(UTrain),将空间推理增强与领域知识学习分离。实验表明,UrbanLLaVA在北京、伦敦、纽约等城市的12项任务测试中表现优异,在单模态和跨模态任务上均超越现有开

前情提要

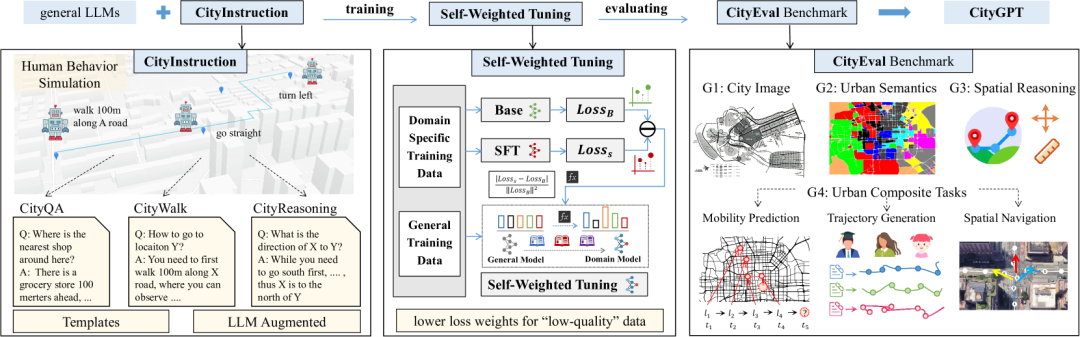

过去一年来,清华大学城市科学与计算研究中心在城市大模型方向持续推进系列工作,从CityGPT到CityBecnh,再到UrbanLLaVA,逐步构建起面向大模型时代的城市时空智能发展框架:首先融合地理空间知识,继而评测多模态大模型的能力,最终深入探索多模态与空间推理相结合的大模型架构。

CityGPT

相关文章和代码见文末“相关阅读”。

摘要

城市研究涉及广泛的场景和任务,需要理解多模态数据。当前的方法通常侧重于特定数据类型,缺乏统一的城市领域框架来全面处理这些数据类型。多模态大型语言模型 (MLLM) 的最新成功为克服这一局限性提供了良好的机会。本文介绍了 UrbanLLaVA,这是一个多模态大型语言模型,旨在同时处理这四种类型的数据,并在各种城市任务中表现出比一般 MLLM 更强大的性能。在 UrbanLLaVA 中,首先构建了一个多样化的城市指令数据集,该数据集包含单模态和跨模态城市数据,涵盖从位置视角到城市环境全局视角的方方面面。此外,提出了一个多阶段训练框架,将空间推理增强与领域知识学习分离,从而提升 UrbanLLaVA 在各种城市任务中的兼容性和后续性能。最后,还扩展了现有的城市研究基准,以评估 MLLM 在各种城市任务中的表现。在三个城市进行的实验结果表明,UrbanLLaVA 在单模态任务和复杂的跨模态任务中均优于开源和专有的 MLLM,并展现出强大的跨城市泛化能力。

Q: 这篇论文试图解决什么问题?

A:这篇论文试图解决如何有效地整合多模态城市数据以实现全面的城市空间理解和复杂的城市任务建模的问题。具体来说,它旨在克服以下几个关键挑战:

-

多模态城市数据的统一建模:

-

城市研究涉及多种模态的数据,包括城市视觉数据(如街景图像)、地理空间数据(如OpenStreetMap数据)、轨迹数据(如Foursquare签到数据)和时空序列数据等。这些数据类型涵盖了城市环境的多方面信息,但它们的异质性使得整合这些数据成为一个重大挑战。

-

当前的方法通常专注于特定数据类型,缺乏一个统一的框架来全面处理这些多模态数据。

-

-

高质量跨模态对齐数据的稀缺性:

-

尽管已有研究提出了各种方法来构建针对不同单模态城市数据的指令调优数据集,但这些努力对于跨多种模态的统一建模来说是不够的。高质量的跨模态对齐数据对于训练能够理解和推理多模态数据的模型至关重要。

-

-

不同城市任务之间的潜在冲突:

-

不同的城市任务可能涉及不同的模态数据,这可能导致训练过程中的不稳定性和性能不一致。例如,某些任务可能需要模型专注于局部信息,而其他任务则需要全局视角。

-

-

现有模型在城市任务中的局限性:

-

现有的多模态大型语言模型(MLLMs)在处理特定领域的任务时表现出色,但在处理涉及多种模态数据的城市任务时,往往缺乏全面的理解和推理能力。

-

为了解决这些问题,论文提出了UrbanLLaVA,这是一个专门设计用于处理四种主要城市数据类型(街景图像、卫星图像、地理空间数据和轨迹数据)的多模态大型语言模型。该模型通过构建高质量的合成数据集、设计有效的多阶段训练框架以及扩展城市任务基准来评估模型性能,从而实现了对城市环境的全面理解和有效任务解决。

Q: 有哪些相关研究?

城市研究中现有成果与UrbanLLaVA对比

A: 论文中提到了与多模态大型语言模型(MLLMs)在城市研究中的应用相关的多个研究工作,这些研究为UrbanLLaVA的提出提供了背景和基础。以下是相关研究的分类和总结:

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

多模态大型语言模型(MLLMs)的研究

-

LLaVA:通过视觉指令调优,训练了第一个开源的多模态大型语言模型,展示了在常见场景中强大的视觉理解和推理能力。

-

VILA:探索了预训练阶段的训练管道和数据格式对视觉语言模型的影响,为多模态模型的训练提供了重要的见解。

-

QwenVL:提出了一个增强视觉语言模型感知能力的模型,通过高质量的指令数据集来提升模型性能。

-

InternVL:通过扩展视觉基础模型并针对通用视觉语言任务进行对齐,进一步提升了多模态模型的性能。

-

ShareGPT4v:通过开发高质量的标题数据来训练标题模型,扩展了数据规模,进一步提升了多模态模型的性能。

多模态模型在城市研究中的应用

-

GeoChat:提出了一个针对遥感任务的多模态大型语言模型,通过将遥感数据与语言模型相结合,提升了对地理空间数据的理解。

-

Mobility-LLM:通过扩展大型语言模型,使其具备处理轨迹数据的能力,从而更好地理解和预测人类的移动模式。

-

CityGPT:设计了一个能够处理结构化地理空间数据的模型,通过将地理空间数据与语言模型相结合,增强了对城市空间的认知。

-

UrbanCLIP:通过将街景图像与地理空间数据相结合,提升了对城市环境的理解和分析能力。

-

CityLens:提出了一个用于城市社会经济感知的多模态语言模型基准,评估了多模态模型在城市研究中的潜力。

城市研究中的多模态数据融合

-

LAMP:提出了一个基于地图的语言模型,将结构化地理空间数据转换为与语言模型兼容的格式,增强了地理空间知识的学习。

-

City Foundation Models:提出了一个从OpenStreetMap学习通用表示的城市基础模型,为城市研究提供了强大的地理空间数据处理能力。

-

UrbanVLP:提出了一个用于城市指标预测的多粒度视觉语言预训练基础模型,通过整合街景图像和遥感数据,提升了对城市环境的理解。

-

AgentMove:提出了一个基于大型语言模型的代理框架,用于零样本的下一个位置预测,展示了在城市移动性预测方面的潜力。

-

UrbanGPT:提出了一个时空大型语言模型,通过引入特定领域的编码器,增强了对时空序列数据的建模能力。

这些相关研究为UrbanLLaVA的提出提供了重要的背景和基础,展示了多模态大型语言模型在城市研究中的潜力和应用前景。

Q: 论文如何解决这个问题?

UrbanLLaVA

A: 论文通过以下几个关键步骤来解决多模态城市数据的统一建模和城市任务的全面理解问题:

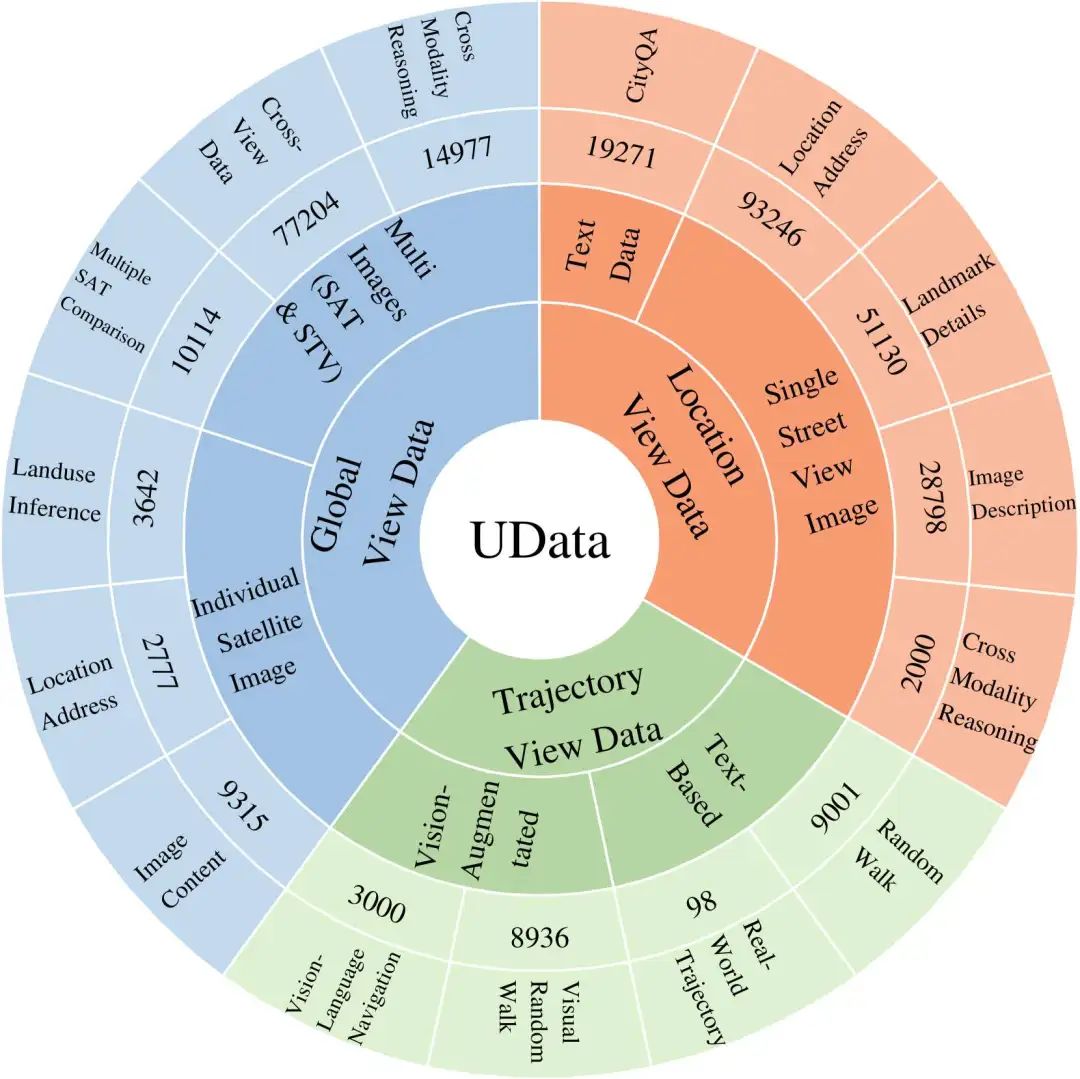

1. 构建高质量的城市指令数据集(UData)

为了有效地整合多模态城市数据,论文首先设计了一个系统化的城市指令数据管道(UData),用于生成高质量的合成数据。这些数据涵盖了从局部视角(单模态数据)到轨迹视角和全局视角(跨模态数据)的多种城市场景,确保了数据的多样性和完整性。

UData

数据来源

-

结构化地理空间数据:来自OpenStreetMap。

-

轨迹数据:包括Foursquare签到数据和OpenStreetMap轨迹。

-

卫星图像:来自Google Earth。

-

街景图像:来自Google Map和Baidu Map。

数据构建

-

局部视角数据:包括结构化地理空间数据和单个街景图像,通过设计问题模板将地理空间数据转换为自然语言问题和答案。

-

轨迹视角数据:包括文本轨迹数据和视觉增强轨迹数据,通过随机采样和真实世界轨迹数据生成。

-

全局视角数据:包括单个卫星图像和多个卫星图像,通过生成描述和比较任务来增强跨模态对齐。

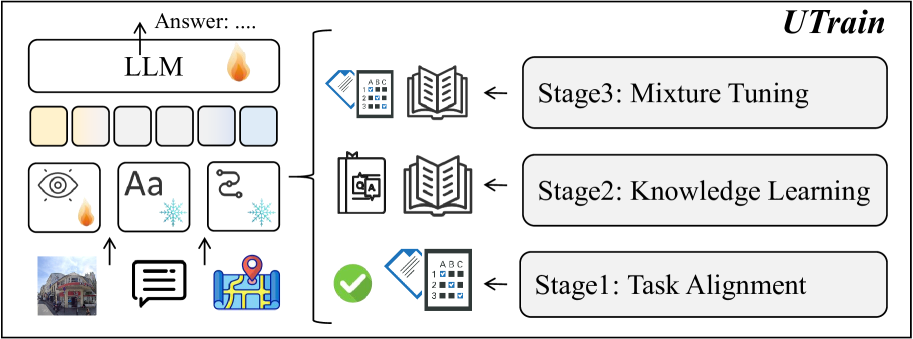

2. 提出多阶段训练框架(UTrain)

为了确保模型在多种城市任务上的稳定性和性能,论文提出了一个三阶段训练框架(UTrain),明确分离了推理能力学习和特定领域知识学习。

UTrain

训练阶段

-

任务对齐(Task Alignment):通过特定的城市任务相关指令对模型进行微调,使其熟悉各种城市任务。

-

知识学习(Knowledge Learning):通过多模态城市数据为模型提供特定领域的知识,增强其对城市环境的理解。

-

混合学习(Mixture Learning):通过混合所有类型的数据进行训练,提升模型在多种任务上的综合性能。

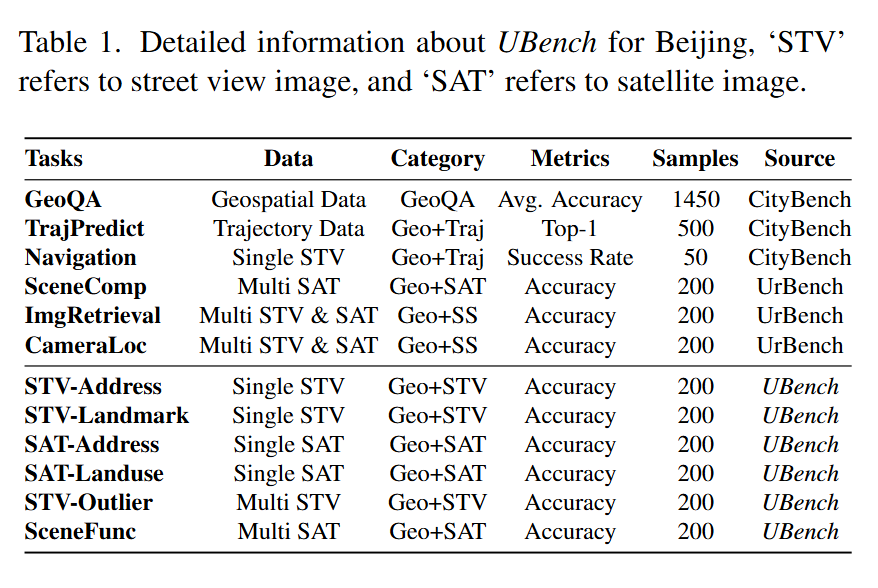

3. 扩展城市任务基准(UBench)

为了评估多模态模型在城市任务中的性能,论文扩展了现有的城市基准(UBench),涵盖了12个不同的城市任务,包括结构化地理空间数据、轨迹建模、跨视图任务等。

UBench

任务分类

-

结构化地理空间数据任务:如GeoQA。

-

轨迹建模任务:如轨迹预测和导航任务。

-

跨视图任务:如图像检索、相机定位和场景比较任务。

-

单视图任务:如地址推断、地标识别和土地利用推断。

-

多视图任务:如STV-Outlier和SceneFunc。

Q: 论文做了哪些实验?

A: 论论文通过一系列实验来验证UrbanLLaVA的有效性和性能,这些实验涵盖了多个城市、多种城市任务以及不同的模型配置。以下是实验的主要内容和结果:

1. 实验设置

-

城市选择:实验在北京、伦敦和纽约三个城市进行,以验证模型在不同城市数据分布上的泛化能力。

-

数据区域选择:由于数据量较大,实验选择了每个城市的一个特定区域进行评估。

-

基准模型选择:实验选择了多种多模态大型语言模型(MLLMs)作为基线,包括Qwen2VL、InternVL2、VILA1.5、LLaMA3.2、GPT4o和GPT4o-mini。

-

评估指标:根据UBench中的任务,使用准确率(Accuracy)、Top-1准确率等指标进行评估。

2. 主要实验结果

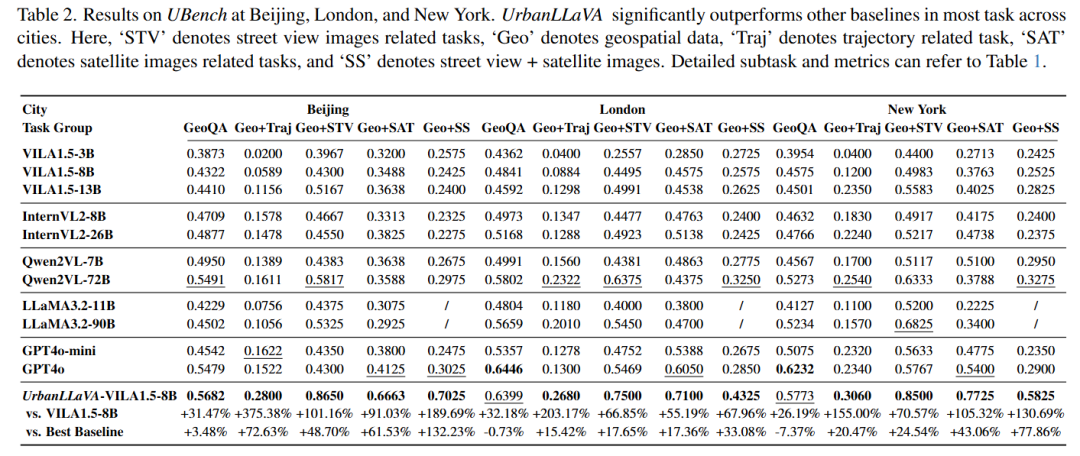

北京、伦敦和纽约的性能对比

-

性能提升:UrbanLLaVA在所有任务上均优于基线模型。与最佳基线模型相比,性能提升范围从3.48%到132.23%。

-

具体任务表现:

-

GeoQA:UrbanLLaVA在GeoQA任务上表现显著优于基线模型,例如在北京的GeoQA任务上,UrbanLLaVA的准确率为56.82%,相比VILA1.5-8B提升了31.47%。

-

轨迹预测(TrajPredict):在轨迹预测任务上,UrbanLLaVA的Top-1准确率在北京为28.00%,相比VILA1.5-8B提升了375.38%。

-

街景图像地址推断(STV-Address):在STV-Address任务上,UrbanLLaVA的准确率为86.50%,相比VILA1.5-8B提升了101.16%。

-

卫星图像土地利用推断(SAT-Landuse):在SAT-Landuse任务上,UrbanLLaVA的准确率为78.50%,相比VILA1.5-8B提升了91.03%。

-

在北京、伦敦和纽约的 UBench 测试结果。在大多数城市的任务中,UrbanLLaVA 的表现显著优于其他基线。此处,“STV” 表示街景图像相关任务,“Geo” 表示地理空间数据,“Traj” 表示轨迹相关任务,“SAT” 表示卫星图像相关任务,“SS” 表示街景 + 卫星图像。详细的子任务和指标可参考表

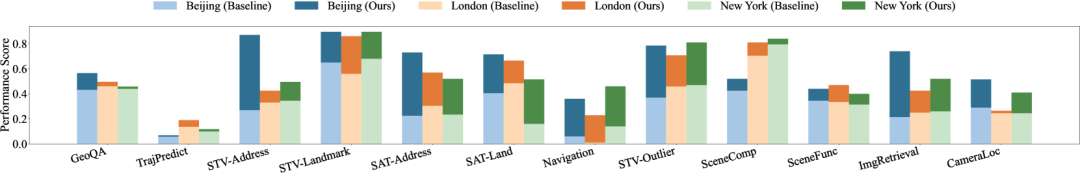

泛化能力

-

跨城市泛化:UrbanLLaVA不仅在训练城市(北京)表现出色,还能泛化到其他城市(伦敦和纽约)。在伦敦和纽约的基准测试中,UrbanLLaVA在大多数任务上均优于基线模型。

从一个城市(北京)学到的知识可以直接推广到其他城市(伦敦和纽约)。在该图中,基线是 VILA1.5 - 8b,而UrbanLLaVA仅使用来自北京的城市指令数据进行训练

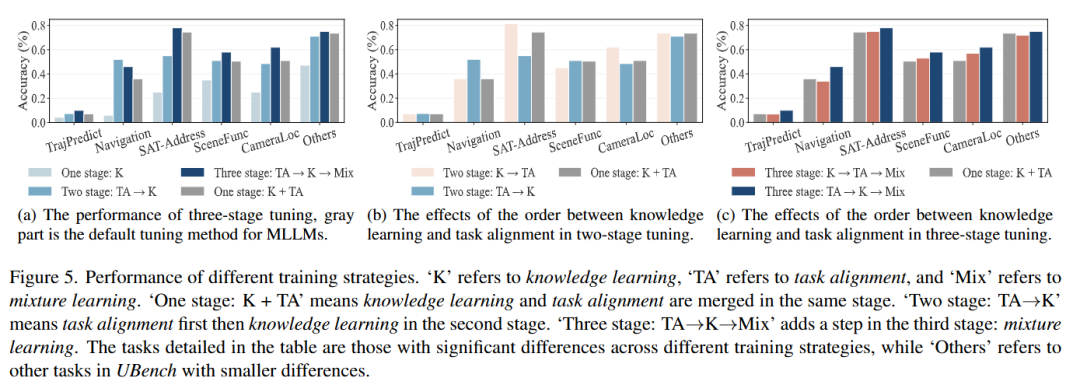

3. 训练策略实验

-

多阶段训练策略:实验验证了三阶段训练策略(任务对齐、知识学习、混合学习)的有效性。结果显示,三阶段训练策略在大多数任务上表现最佳,且性能稳定。

-

任务对齐(TA)→知识学习(K)→混合学习(Mix):这种顺序的训练策略在多个任务上表现优于其他策略,例如在TrajPredict任务上,三阶段策略的准确率为28.00%,相比单一阶段训练提升了显著的性能。

-

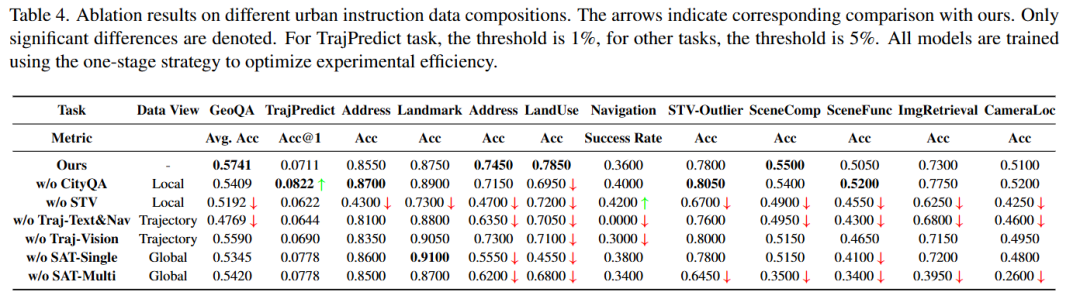

不同城市指令数据构成的消融实验结果

4. 数据消融实验

-

局部视角数据:移除局部视角数据后,模型在多个任务上的性能显著下降,表明局部视角数据对城市理解的重要性。

-

轨迹视角数据:移除轨迹视角数据后,模型在导航任务上的性能下降,表明轨迹视角数据对连续空间知识的重要性。

-

全局视角数据:移除全局视角数据后,模型在全局任务(如图像检索和相机定位)上的性能下降,表明全局视角数据对全局城市理解的重要性。

不同城市指令数据构成的消融实验结果

5. 案例研究

-

SceneFunc任务:模型需要识别哪个卫星图像包含最多的特定类型兴趣点(POIs)。UrbanLLaVA成功地识别了正确答案,展示了其多图像理解和比较的能力。

SceneFunc任务的一个示例,其中正确答案为绿色,错误答案为红色

-

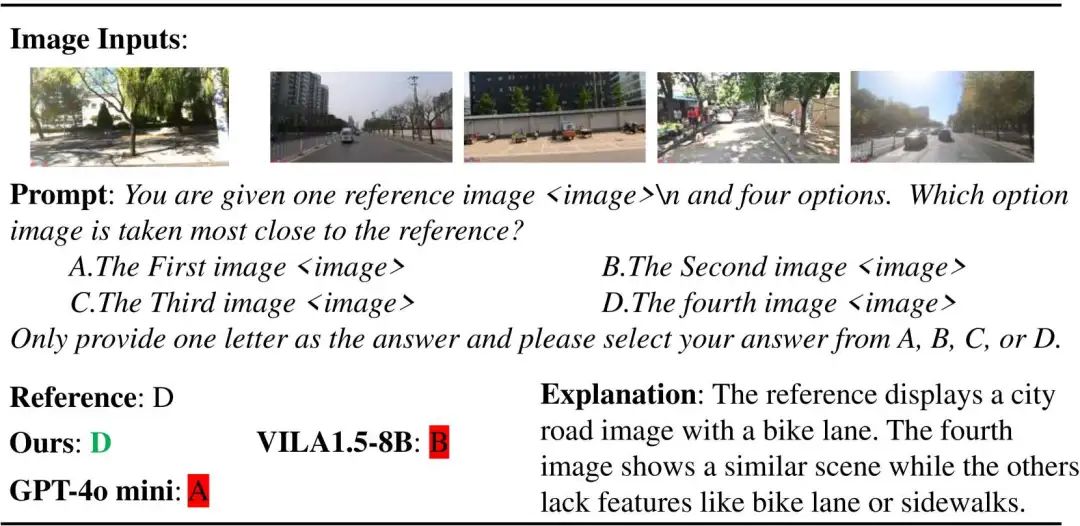

STV-Outlier任务:模型需要从多个街景图像中识别出与参考图像最接近的图像。UrbanLLaVA在这一任务上表现优于基线模型,展示了其在多图像理解和逻辑推理方面的优势。

STV-Outlier 任务示例

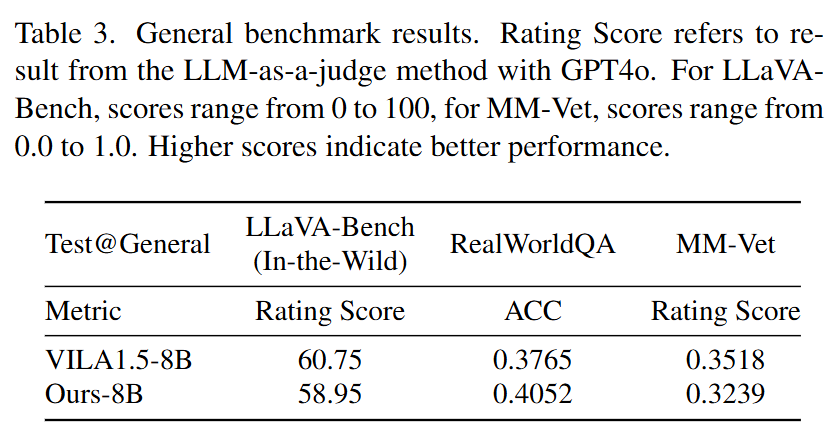

6. 通用基准测试

-

LLaVA-Bench(In-the-Wild):UrbanLLaVA在这一基准测试中的表现与基线模型相当,表明其在一般视觉任务上的竞争力。

-

RealWorldQA:UrbanLLaVA在这一基准测试中的准确率为40.52%,优于基线模型,表明其在真实世界空间理解任务上的能力。

-

MM-Vet:UrbanLLaVA在这一基准测试中的评分为0.3239,优于基线模型,表明其在综合能力上的竞争力。

通过这些实验,论文全面验证了UrbanLLaVA在多模态城市数据整合和城市任务解决方面的有效性和性能,展示了其在不同城市和任务上的泛化能力。

大模型&AI产品经理如何学习

求大家的点赞和收藏,我花2万买的大模型学习资料免费共享给你们,来看看有哪些东西。

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

1.学习路线图

第一阶段: 从大模型系统设计入手,讲解大模型的主要方法;

第二阶段: 在通过大模型提示词工程从Prompts角度入手更好发挥模型的作用;

第三阶段: 大模型平台应用开发借助阿里云PAI平台构建电商领域虚拟试衣系统;

第四阶段: 大模型知识库应用开发以LangChain框架为例,构建物流行业咨询智能问答系统;

第五阶段: 大模型微调开发借助以大健康、新零售、新媒体领域构建适合当前领域大模型;

第六阶段: 以SD多模态大模型为主,搭建了文生图小程序案例;

第七阶段: 以大模型平台应用与开发为主,通过星火大模型,文心大模型等成熟大模型构建大模型行业应用。

2.视频教程

网上虽然也有很多的学习资源,但基本上都残缺不全的,这是我自己整理的大模型视频教程,上面路线图的每一个知识点,我都有配套的视频讲解。

(都打包成一块的了,不能一一展开,总共300多集)

因篇幅有限,仅展示部分资料,需要点击下方图片前往获取

3.技术文档和电子书

这里主要整理了大模型相关PDF书籍、行业报告、文档,有几百本,都是目前行业最新的。

4.LLM面试题和面经合集

这里主要整理了行业目前最新的大模型面试题和各种大厂offer面经合集。

👉学会后的收获:👈

• 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习框架等技术,这些技术的掌握可以提高程序员的编码能力和分析能力,让程序员更加熟练地编写高质量的代码。

1.AI大模型学习路线图

2.100套AI大模型商业化落地方案

3.100集大模型视频教程

4.200本大模型PDF书籍

5.LLM面试题合集

6.AI产品经理资源合集***

👉获取方式:

😝有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

更多推荐

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)